BF Skinner: Teoria behawioryzmu i klimatyzacji operacyjnej

Burrhus Frederic Skinner, lepiej znany jako BF Skinner, był amerykańskim psychologiem znanym ze swojego wkładu w rozwój teorii behawiorystycznej i jego utopijnej powieści Walden Two (1948).

Behawioryzm zakłada, że wszystkie zachowania są reakcją na pewne bodźce w środowisku lub konsekwencje historii jednostki. Chociaż behawioryści ogólnie akceptują ważną rolę dziedziczenia w określaniu zachowania, skupiają się głównie na czynnikach środowiskowych.

Jest najbardziej znanym psychologiem w nurcie behawioryzmu, a jego teoria jest jednym z najbardziej wpływowych w psychologii.

Urodził się w Pensylwanii w 1904 roku. Rozpoczął pracę nad swoimi pomysłami na ludzkie zachowanie po uzyskaniu doktoratu na Harvardzie. Prace Skinnera obejmują The Behavior of Organisms (1938) i powieść opartą na jego teoriach Walden Two (1948). Badał behawioryzm w odniesieniu do społeczeństwa w późniejszych książkach, w tym w Beyond Freedom and Human Dignity (1971).

Jako student w Hamilton College, Skinner rozwinął pasję do pisania. Po ukończeniu studiów w 1926 r. Próbował zostać zawodowym pisarzem, ale odniósł niewielki sukces. Dwa lata później postanowił pójść w nowym kierunku swojego życia; Zapisał się na Uniwersytet Harvarda, aby studiować psychologię.

Skinner uważany za wolną wolę jest iluzją i ludzkim działaniem zależnym od konsekwencji poprzednich działań. Jeśli konsekwencje są złe, istnieje duże prawdopodobieństwo, że akcja się nie powtórzy. Wręcz przeciwnie, jeśli konsekwencje są dobre, prawdopodobne jest, że akcja zostanie powtórzona. Skinner nazwał to zasadą wzmocnienia.

Aby wzmocnić zachowanie, Skinner użył kondycjonowania operantem i do badania go wynalazł komorę kondycjonującą operant, znaną również jako pudełko Skinnera.

W latach dwudziestych Watson opuścił psychologię akademicką i innych behawiorystów, którzy zaczęli być wpływowi, proponując nowe sposoby uczenia się oprócz warunkowania klasycznego.

Sposób myślenia Skinnera był nieco mniej ekstremalny niż sposób myślenia Watsona. Skinner wierzył, że mamy umysł, ale po prostu bardziej produktywne jest badanie obserwowalnych zachowań niż wewnętrznych zdarzeń umysłowych.

Wprowadzenie do behawioryzmu

Behawioryzm był głównym paradygmatem psychologii między 1920 a 1950 r., Założonym przez Johna Watsona i opartym na przekonaniu, że zachowania można mierzyć, szkolić i zmieniać. Behawioryzm można podsumować następującym cytatem z Watsona, uważanego za „ojca” tego psychologicznego nurtu:

„Daj mi tuzin zdrowych, dobrze wykształconych dzieci, abym mogła je kształcić, i obiecuję, że wybiorę jedną z nich losowo i wyszkolę ją, by stała się specjalistką od wszystkiego, co mogę wybrać: lekarza, prawnika, artysty, biznesmena, żebraka lub złodziej, niezależnie od jego talentu, skłonności, skłonności, uzdolnień, powołań i rasy swoich przodków ”.

John Watson, Behaviorism, 1930.

Zgodnie z zasadami behawioryzmu wszystkie zachowania są wyciągane ze środowiska, w którym się rozwijamy. Behawioryści nie wierzyli w determinacje biologiczne.

Ponadto zajmowali się głównie zachowaniami, które można zaobserwować, i wierzyli, że nie ma dużej różnicy między uczeniem się, które ma miejsce u ludzi, a tym, co ma miejsce u zwierząt.

Jak zaczął się behawioryzm?

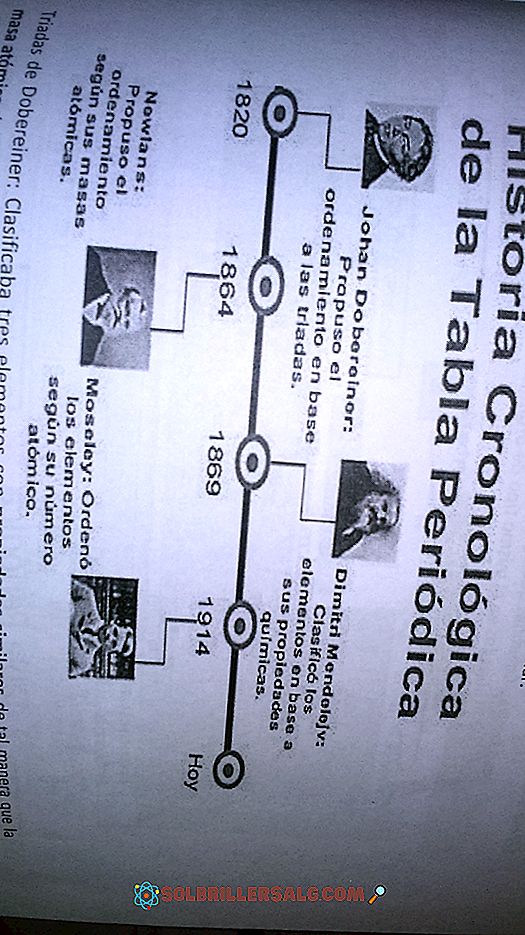

Rosyjski doktor Pavlov był pierwszym, który studiował teorie dotyczące behawioryzmu w latach 90. XIX w. Pawłowskie uwarunkowania klasyczne odkryto przypadkiem, gdy odkrył w eksperymencie dotyczącym trawienia swoich psów, że zasiedli, gdy wszedł do pokoju, nawet nie przynosząc ze sobą jedzenia.

Podsumowując, warunkowanie klasyczne implikuje uczenie się, które wiąże nieuwarunkowany bodziec, który domyślnie wywołuje reakcję w organizmie (na przykład odruch) z nowym bodźcem, tak że ten ostatni również niesie tę samą odpowiedź.

Teoria ta została później opracowana przez Watsona (1913), który był amerykańskim psychologiem, który założył behawioralną szkołę psychologiczną, publikując artykuł zatytułowany „Psychologia widziana przez behawiorystę”. Później uwarunkował dziecko, by bało się białego szczura.

Thorndike, amerykański psycholog i pedagog, sformalizował termin „Prawo efektu” w 1905 r. W 1936 r. Skinner, amerykański psycholog, który skupił się na tym artykule, opublikował „Zachowanie organizmów” i przedstawił koncepcje warunkowania operantowego i modelowania.

Behawioryzm według Burrhus Frederic Skinner

Prace Skinnera były zakorzenione w postrzeganiu warunkowania klasycznego jako zbyt prostego, aby stanowić kompletne wyjaśnienie złożonego zachowania człowieka. Skinner uważał, że najlepszym sposobem na zrozumienie ludzkich zachowań jest sprawdzenie przyczyn działania i jego konsekwencji. Nazwał to podejście „warunkowaniem operacyjnym”.

Kondycjonowanie operacyjne ma związek z operantem: celowe działania, które mają wpływ na otaczające nas środowisko. Skinner zaczął identyfikować procesy, które sprawiały, że występowanie pewnych zachowań operacyjnych było mniej lub bardziej prawdopodobne.

Teoria warunkowania operantowego Skinnera opiera się na pracy Thorndike'a (1905). Edward Thorndike studiował naukę na zwierzętach za pomocą pudełka z puzzlami, aby zaproponować teorię znaną jako „Prawo efektu”.

Kondycjonowanie operanta Skinnera

Jak już powiedzieliśmy, Skinner jest uważany za ojca warunkowania operantowego, ale jego praca opiera się na prawie efektu Thorndike'a. Skinner wprowadził nowy termin w prawie efektu: wzmocnienie. Wzmocnione zachowanie ma tendencję do powtarzania się; zachowanie, które nie jest wzmocnione, zwykle wygasa (słabnie).

Skinner studiował warunkowanie operantów, przeprowadzając eksperymenty na zwierzętach, które umieścił w „pudełku Skinnera”, podobnym do pudełka układanki Thorndike'a.

Skinner ukuł termin „warunkowanie operantowe”, które polega na zmianie zachowania za pomocą wzmocnień podanych po pożądanej odpowiedzi. Skinner zidentyfikował trzy typy odpowiedzi lub argumentów, które mogą śledzić zachowanie:

- Operatorzy neutralni. Są to reakcje środowiska, które nie zwiększają ani nie zmniejszają prawdopodobieństwa, że zachowanie się powtórzy.

- Odpowiedzi te zwiększają prawdopodobieństwo, że zachowanie się powtórzy. Wzmocnienia mogą być dodatnie lub ujemne.

- Są to odpowiedzi, które zmniejszają prawdopodobieństwo, że zachowanie się powtórzy; kary osłabiają dane zachowanie.

Wszyscy doświadczyliśmy przykładów zachowań, na które wpłynęły posiłki i kary. Kiedy byliśmy dziećmi, na przykład, gdy rozmawialiśmy podczas zajęć, nauczyciel powiedział nam, abyśmy milczeli. Ta odpowiedź nauczyciela jest karą, która przynajmniej rzekomo powinna osłabić zachowanie podczas rozmowy z koleżanką z klasy.

Na przykład w okresie dojrzewania noszenie określonego stylu lub marki odzieży może być pozytywnie wzmocnione przez rówieśników w tym samym wieku poprzez pochlebstwa, akceptację społeczną lub po prostu miły gest. Wzmacnia to i sprawia, że jest bardziej prawdopodobne, aby powtórzyć zachowanie nosząc określone ubrania marki.

Pozytywne wzmocnienie

Skinner zademonstrował, jak działa pozytywne wzmocnienie, umieszczając głodnego szczura w pudełku Skinnera. Pudełko zawierało dźwignię po jednej stronie, a szczur, gdy przechodził przez skrzynkę, przypadkowo nacisnął dźwignię. Natychmiast granulka jedzenia wpadła do małego pojemnika obok dźwigni.

Szczury szybko nauczyły się podchodzić bezpośrednio do dźwigni, po tym jak kilka razy znalazły się w pudełku. Konsekwencją otrzymania pożywienia, gdyby nacisnęli dźwignię, było zapewnienie, że będą powtarzać to zachowanie w kółko.

Pozytywne wzmocnienie wzmacnia zachowanie, zapewniając konsekwencję, którą jednostka uważa za satysfakcjonującą. Na przykład, jeśli twój nauczyciel daje ci pieniądze za każdym razem, gdy wykonujesz pracę domową, jest bardziej prawdopodobne, że powtórzysz zachowanie odrabiania lekcji w przyszłości, wzmacniając to zachowanie.

Ujemne wzmocnienie

Usunięcie nieprzyjemnego wzmocnienia może również wzmocnić pewne zachowanie. Jest to znane jako wzmocnienie negatywne, ponieważ jest to eliminacja niekorzystnego bodźca, który „wynagradza” osobę lub zwierzę. Ujemne wzmocnienie wzmacnia zachowanie, ponieważ zatrzymuje lub eliminuje nieprzyjemne doświadczenie.

Na przykład, kiedy boli cię głowa, bierzesz aspirynę, żeby to ulżyć. Fakt, że ból znika, jest negatywnym czynnikiem wpływającym na zachowanie aspiryny, co zwiększa prawdopodobieństwo powtórzenia się w przyszłości, gdy boli cię głowa.

Skinner ponownie zbadał, jak działa negatywne wzmocnienie, umieszczając szczura w pudełku Skinnera i wystawiając go na nieprzyjemny prąd elektryczny, który powodował u niego pewien dyskomfort. Tym razem dźwignia skrzynki spowodowała zatrzymanie prądu elektrycznego.

Na początku szczury przez przypadek nacisnęły dźwignię, ale wkrótce nauczyły się ją naciskać, aby zatrzymać prąd elektryczny. Konsekwencja ucieczki do strumienia zapewniła, że będą powtarzać akcję za każdym razem, gdy zostaną umieszczeni w skrzynce lub gdy poczują elektryczność.

W rzeczywistości Skinner nauczył szczury nawet unikać prądu elektrycznego, włączając światło tuż przed pojawieniem się prądu elektrycznego. Szczury nauczyły się wcześnie naciskać dźwignię, gdy światło się zapaliło, ponieważ wiedziały, że zapobiegnie to włączeniu prądu elektrycznego.

Te dwie wyuczone odpowiedzi są znane jako „uczenie się przez ucieczkę” i „uczenie się przez unikanie”.

Kara

Kara jest definiowana jako przeciwieństwo wzmocnienia, ponieważ ma na celu osłabienie lub wyeliminowanie odpowiedzi zamiast zwiększania jej prawdopodobieństwa. Jest to awersyjne wydarzenie, które zmniejsza zachowanie, które następuje.

Podobnie jak w przypadku wzmacniania, kara może działać albo bezpośrednio, stosując nieprzyjemny bodziec, taki jak porażenie prądem po odpowiedzi, albo eliminując potencjalnie satysfakcjonujący bodziec.

Na przykład zdyskontowanie pieniędzy z czyjegoś wynagrodzenia w celu ukarania niepożądanych zachowań. Należy podkreślić, że nie zawsze łatwo jest odróżnić kary od negatywnych wzmocnień.

Podczas używania kar występuje kilka problemów, takich jak:

- Karane zachowanie nie jest zapomniane, jest tłumione. To zachowanie powraca, gdy kara nie jest obecna.

- Kara może spowodować wzrost agresji. Może to pokazać, że agresywność jest sposobem radzenia sobie z problemami.

- Kary powodują strach, który generalizuje niepożądane zachowania, na przykład strach przed pójściem do szkoły.

- Wiele razy kara nie modeluje zachowania w kierunku pożądanego celu. Wzmocnienie mówi ci, co masz robić, podczas gdy kara mówi tylko, czego nie robić.

Modelowanie zachowań

Innym ważnym wkładem Skinnera jest pojęcie modelowania behawioralnego poprzez kolejne przybliżenia. Skinner twierdzi, że zasady warunkowania operantowego można wykorzystać do wytworzenia niezwykle złożonych zachowań, jeśli nagrody i kary są wykonywane w sposób, który zachęca dany organizm do zbliżania się do pożądanego zachowania.

Aby ten wynik miał miejsce, warunki (lub przypadkowe) wymagane do otrzymania nagrody powinny się zmieniać za każdym razem, gdy organizm robi krok, aby być bliżej pożądanego zachowania.

Według Skinnera większość ludzkich zachowań (w tym język) można wytłumaczyć jako produkt tego rodzaju kolejnego przybliżenia.

Modyfikacja zachowania

Modyfikacja zachowania to zestaw terapii lub technik opartych na warunkowaniu operacyjnym. Podstawową zasadą jest zmiana zdarzeń środowiskowych związanych z określonym zachowaniem osoby. Na przykład wzmocnij pożądane zachowania i zignoruj lub ukaraj niechciane.

Nie jest to jednak takie proste, jak się wydaje. Na przykład, aby zawsze wzmacniać pożądane zachowanie, zasadniczo należy kogoś przekupić.

Istnieje kilka rodzajów pozytywnego wzmocnienia. Wzmocnienie pierwotne występuje wtedy, gdy nagroda wzmacnia samo zachowanie. Wtórne wzmocnienie występuje, gdy coś wzmacnia zachowanie, ponieważ prowadzi do wzmocnienia podstawowego.

Praktyczne aplikacje edukacyjne

W konwencjonalnej sytuacji uczenia się warunkowanie operanta odnosi się do tematów związanych z salami lekcyjnymi i nauką, a nie do treści związanych z nauką.

Jeśli chodzi o edukacyjną aplikację modelowania behawioralnego, prostym sposobem modelowania zachowania jest przekazanie informacji zwrotnej (zwrotnej) na temat wyników ucznia (na przykład komplementów, sygnałów zatwierdzenia, zachęty).

Na przykład, jeśli nauczyciel chciałby zachęcić swoich uczniów do odpowiedzi na pytania w klasie, powinien je chwalić za każdym razem, niezależnie od tego, czy odpowiedź jest poprawna, czy nie. Stopniowo nauczyciel będzie chwalił uczniów tylko wtedy, gdy ich odpowiedzi będą poprawne i z czasem będą chwalone tylko wyjątkowe odpowiedzi.

Niechciane zachowania, takie jak opóźnienia po przyjeździe na zajęcia i dominują dyskusje w klasie, można wygasić, ignorując je od nauczyciela, zamiast wzmacniać je, przyciągając uwagę nauczyciela do tych zachowań.

Ważna jest również wiedza o tym, że odniosłeś sukces, ponieważ motywuje to do dalszej nauki. Ważne jest jednak, aby zmienić rodzaj wzmocnień, które są zapewnione, aby zachowanie było zachowane. Nie jest to proste zadanie, ponieważ nauczyciel może wydawać się nieszczęśliwy, jeśli zbyt wiele myśli o tym, jak powinien zachowywać się, gdy chwali ucznia.

Inne praktyczne zastosowania i krytyczna ocena

Kondycjonowanie operacyjne można wykorzystać do wyjaśnienia dużej liczby zachowań, od procesu uczenia się po uzależnienie i przyswajanie języka. Ma również praktyczne zastosowania, takie jak te, które opisaliśmy wcześniej, w więzieniach, szpitalach psychiatrycznych i ekonomii.

W ekonomii znanym zastosowaniem warunkowania operantowego jest ekonomia symboliczna, system, w którym osoba otrzymuje żetony tuż po wykonaniu pożądanego zachowania. Żetony są zbierane, a następnie wymieniane na jakiś znaczący przedmiot dla jednostki.

Wykorzystanie badań na zwierzętach w warunkowaniu operantów również rodzi pytanie o ekstrapolację wyników.

Niektórzy psycholodzy twierdzą, że nie możemy uogólniać na ludzkie zachowania wyników badań ze zwierzętami, ponieważ ich anatomia i fizjologia są różne i nie mogą odzwierciedlać swoich doświadczeń ani wywoływać rozumu, cierpliwości i pamięci jako ludzie.